通信世界网消息(CWW)人工智能领域正在经历一场深刻变革,其核心驱动力之一是大型语言模型(LLM)如DeepSeek的成熟与广泛应用。这些模型在展现出强大能力的同时,也促使市场对算力的需求发生了巨大变化。过去,人工智能算力的投入高度集中在模型预训练阶段,若要训练千亿/万亿参数规模的AI模型需要消耗海量样本数据和极其庞大的计算资源;然而Deepseek通过“算法+工程”创新方式提升了模型的推理能力和效率,推理成本被压缩至OpenAI同类模型的1/30到1/40,API调用价格仅为行业标准的3%-5%,这使得中小型企业和开发者能够以更低的成本获取强大的AI能力,算力需求的重心由“训练侧”快速向“推理侧”倾斜,预计到2027年推理负载将达到72.6%。

Deepseek的开源模式大幅降低了AI应用的门槛,用户推理需求激增。据统计,Deepseek上线20天累计新增用户1.25亿,日活用户数超2000万,1月28日的单日访问量更是高达4900万次。但用户的高并发访问请求,造成服务器资源迅速耗尽,用户在访问Deepseek网页时经常遇到“服务器繁忙,请稍后再试”的问题。2月6日DeepSeek官方称,由于服务器资源紧张,已暂停API服务的充值功能。针对因单点智算中心规模受限,难以满足海量用户并发算力需求的问题,运营商亟需利用自有网络资源、算力资源以及边缘计算能力,构建全新分布式推理架构,通过多节点云、边协同,为用户提供无处不在的低时延推理服务。

中国电信推理资源池布局情况

目前,中国电信正在积极优化算力布局,针对推理场景提出“大规模中心+小规模省级边缘”的协同架构需求。依托“4+31+X”的分级算力体系,有效整合分散的算力资源,实现全国无缝覆盖、资源动态调配与任务智能卸载,从而打造一张灵活高效、弹性可扩展的分布式推理网络。具体来说:

4:在京津冀、长三角、粤港澳、川渝4个热点区域中心集中建设千卡以上规模推理池,兼顾行业模型精调/微调、推理、渲染服务;

31:在31省按需建设百卡—千卡规模推理池,满足模型推理为主,微调为辅的服务,例如Aone/云电脑等云智一体产品省级推理、视联网CV类小模型推理等;

X:在地市边缘按需建设百卡规模推理池,以满足多样化、低时延的推理服务请求为主,例如边缘实时云渲染、省属国企属地化推理、智能网联汽车边缘推理等业务。此外,在端侧也可部署智能一体机或终端设备承接本地私有化推理需求,满足极致低时延和数据安全要求。

基于中国电信现有资源池情况,采用云-边协同的分布式推理架构既可以整合零散算力,扩大算力规模,提供高并发、低时延推理服务;又可以提高推理的速度和精度,降低整体推理成本,是目前主流的推理部署方式。

云-边协同分布式推理场景

云训边推

在典型的云训边推场景下,云端的大模型通过蒸馏方式生成多个轻量级的小模型,这些小模型被分别部署到不同的边缘节点上进行推理。但由于小模型泛化能力较弱,当场景发生变化时,推理精度可能会急剧下降,导致预测结果不可靠。因此,边缘小模型在推理过程中,会将高价值(代表模型当前“知识盲区”的数据样本)数据传输回云端。云端的大模型利用这些反馈数据作为增量训练集,进行进一步训练或微调。最后,云端将重新蒸馏后获取的模型参数更新到对应边缘节点上。这种云训边推方式将云端的强大学习能力与边缘的实时响应优势相结合,通过持续的知识蒸馏和定向反馈更新,构建了一个具备自我诊断、自我学习和自我进化能力的智能分布式推理网络。但在推理过程中,高价值数据可能涉及用户隐私信息,且模型参数下发过程中可能被窃取或篡改。因此,需要对云边交互通道进行加密,保证推理服务正常运行。

大小模型协同推理

大小模型协同策略包括以下两种:一是兼顾推理速度和精度,小模型在边缘侧推理延迟很低,可以让小模型先行给出初步结果,再由云端大模型对结果进行校正提高精度。二是自适应推理分发,将全量模型(如DeepSeek-671B)部署在云端,针对复杂任务进行推理;将通过大模型蒸馏后的小模型(如1.5B/7B/70B)部署在边缘节点,先由边缘节点的小模型判断问题难易后,再将不同推理请求自适应调度到边缘小模型或云端全量模型进行推理,同时由云端大模型对边缘小模型生成的结果进行批量校验。

PD分离分布式推理

DeepSeek开源发布促使企业私有化部署需求激增,中小型企业广泛基于基础模型进行微调、蒸馏,以获得能力更强的行业模型,并在此基础上进行进一步推理,企业推理业务迅速增长。对于某些数据敏感行业(如政府、国企、金融、医疗),对数据安全提出较高要求,也多选择本地部署避免数据泄露。但中小型企业往往仅在本地部署少量私有算力,无法满足用户高并发、低时延的推理服务需求。企业可通过自建机房扩大算力规模,但成本较高,且运维难度大;若直接租用运营商算力,则会存在隐私数据泄露的风险。因此,可采用“企业自建+云端算力租用”的云边协同分布式推理部署方式,在支持企业弹性扩容的同时,降低综合成本。

目前,业界已普遍认可PD分离部署的优势。一方面,PD分离能够有效提升高并发、长序列、低成本需求场景下的推理性能。例如,Azure的Splitwise采用PD分离推理,成本降低20%的情况下,吞吐量提升1.4倍;月之暗面Kimi的Mooncake采用PD分离推理,有效吞吐平均提升1.75倍,特定场景提升5.25倍。另一方面,PD分离架构天然支持分布式推理部署,可以通过多节点协同整合零散算力资源,构建更大规模的算力池,提供海量用户高并发的推理服务。同时PD池间仅传递中间缓存数据(KVCache),也保证用户原始数据不出园区,确保隐私数据安全。因此,基于PD分离的云边协同分布式推理架构有望成为未来主流的分布式推理模式。以利用Qwen-72B模型推理为例,本地私有化部署需构建128卡的GPU集群,对于某些企业来说成本较高;而采用PD分离分布式推理方式,仅需本地(P)部署8张算卡,云端(D)租用运营商120张算卡,显著降低综合成本。

但在PD分离分布式推理架构下,云、边之间要传输KV Cache数据,KV Cache大小通常从MB到GB级,为了保障用户推理SLA要求,需要P、D池间具备大带宽、低时延网络。此外,由于不同智算中心内可能部署不同厂商的算卡,导致自有资源与租用资源在设备型号与参数、管理要求与配置上异构,无法有效协同工作。因此需要开发兼容异构GPU通信的统一集合通信库,并采用端网协同的异构分布式计算架构,实现跨域异构算力的统一管控、调度。

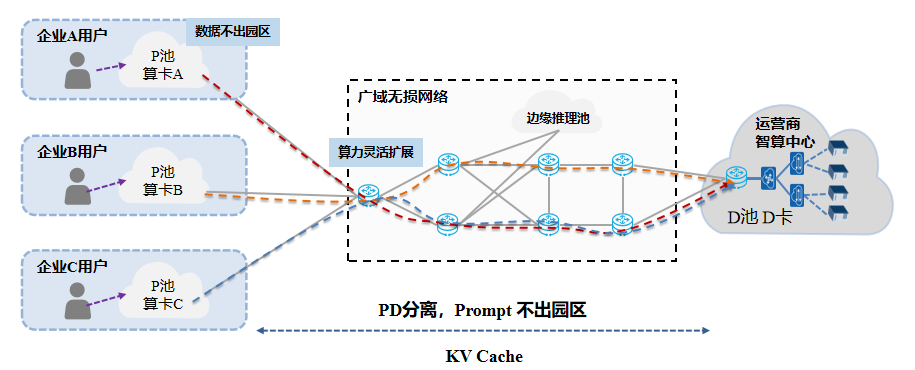

图1 异构PD分离分布式推理

PD分离分布式推理过程中,推理的结果有时也可能包含输入序列的一些信息,严格来说是有风险的。为了进一步确保企业隐私数据安全,保证推理过程中原始数据与输出结果都不出园区,可采用Split Learning技术对模型进行切分。例如将Prefill模型以及Decode模型的前几层与最后几层部署在本地用户侧,将Decode模型的中间几层部署在云端,P、D池间仅传递KV Cache数据以及中间激活值。本地支持KV Cache复用降低算力开销,云端可弹性扩展Decode算力规模支持高并发。

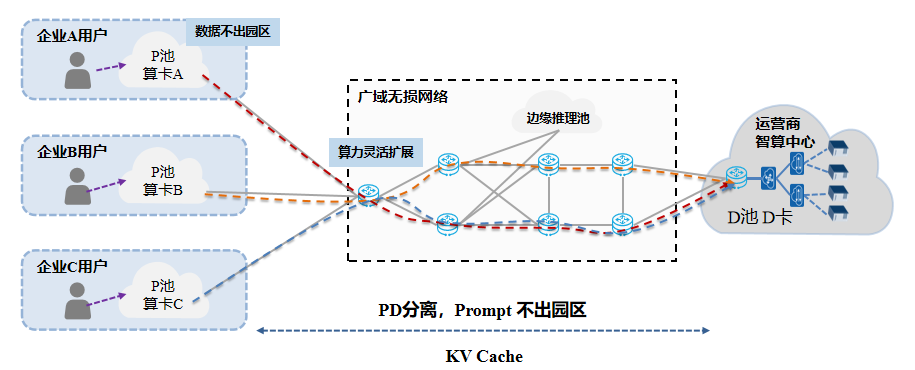

图2 PD-D分离分布式推理

目前,中国电信依托上海400GE智算实验网和广东800G OTN传输系统,完成业界首个DeepSeek-R1-Distill-Llama-70B模型在带宽收敛场景下的PD分离分布式推理现网试验。试验结果表明:与PD分离本地部署方式相比,百公里PD分离分布式推理场景下的TTFT(首token响应时延)、TPOT(Token间时延)满足率劣化均低于2%,PD分离分布式推理具有可行性。后续中国电信将进一步基于PD-D分离分布式推理架构开展试验验证,在满足用户高并发推理需求的同时,确保用户隐私数据安全。

随着AI应用的爆发式增长,推理将超越训练成为算力需求的最大推手。为了应对海量用户高并发推理挑战,中国电信提出了全新分布式推理网络,通过云训边推、大小模型协同、PD分离分布式推理等多种云边协同分布式方式,解决高并发场景下单点智算中心推理能力不足的问题。未来,中国电信将持续发挥自身在算力资源、网络资源方面的优势,联合产业界合作伙伴,攻关分布式推理关键技术,推动AI普惠化发展。