通信世界网消息(CWW)日前,大量美国互联网应用的服务几乎在同一时间集体掉线,迪士尼+的剧集停播、麦当劳应用程序无法点餐、联合航空值机系统瘫痪……这一系列连锁反应原来系亚马逊云服务(AWS)再次突发严重系统故障。

这场持续了超15小时的故障,不仅蔓延到AWS的核心服务,引发全球连锁反应,更被业内称为近年来最严重的宕机事故之一。故障修复之余,这也对行业抛出了灵魂拷问,全球领先的云服务商为何不可靠?云端时代的“断网魔咒”为何屡破不止?

宕机突发背后

小漏洞引发大崩塌

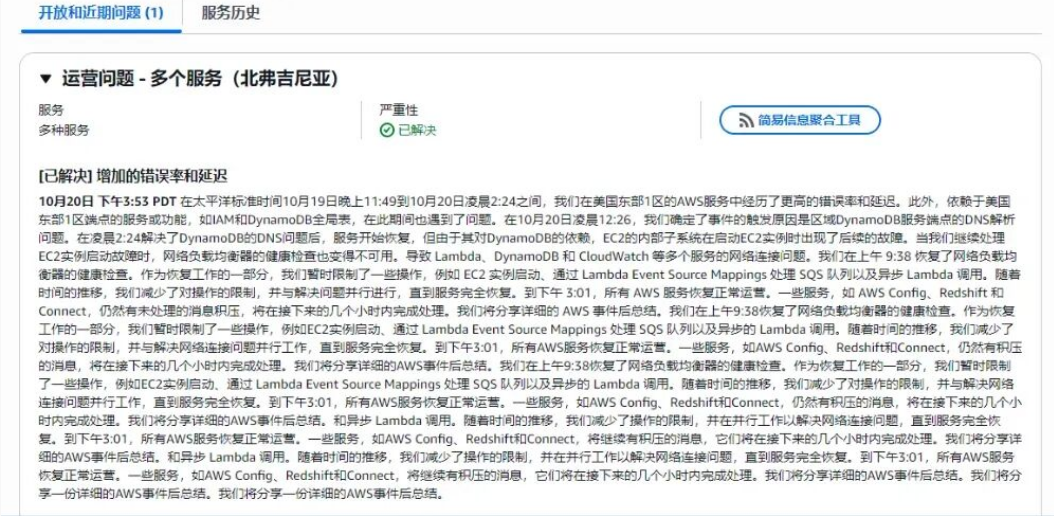

根据AWS官方公告披露,此次故障的“根源”藏在最基础的网络环节。当地时间10月19日晚上11:49,AWS的核心节点之一美国东部1区(US-EAST-1)首先报告出现“显著的错误率和延迟”现象,在10月20日凌晨0:26,AWS确定事件的触发原因为区域DynamoDB(AWS旗下云原生数据库)服务端点的DNS解析问题。

所谓DNS(域名系统),是一种将网址转换为IP地址的系统,是互联网的核心基础设施,也是名副其实的互联网导航系统。其一旦失灵,就意味着客户端无法把DynamoDB的域名以正常的速度解析成正确的IP地址,从而导致了后续一连串服务故障。

其中包括EC2、Lambda、S3、CloudFormation等多个产品在内的“多服务操作问题”。一直截止到10月20日下午3:01,所有AWS服务才恢复正常运营。

不仅如此,此次中断的波及范围极广。短短几个小时内,Downdetector监控到来自500多个网站的用户报告数量翻倍,达到400万份,并最终在恢复尝试过程中达到650万的峰值。有专家指出,这次事件不仅是一次技术故障,更是一场关于互联网脆弱性和集中化风险的全球警示。

谈及AWS此次服务中断带来的经济损失,Catchpoint的CEO Mehdi Daoudi指出,如果将本次宕机的后续影响、公司停业损失和“数百万名无法进行工作的员工的生产力损失”都考虑在其中,累计损失金额将会是数百亿美元乃至千亿美元。

故障背后的深层答案与行业启示

值得注意的是,这并非AWS首次遭遇大规模服务中断,作为云行业的标杆企业,其故障史早已暴露出了核心区域过度依赖的积弊。

2021年12月,US-East-1区域服务器供电故障引发连锁反应,亚马逊配送业务停滞,Netflix、Twitter等平台离线超6小时,被业内称为“年度云端灾难”。

2022年12月,US-WEST-2区域网络设备故障,引发大规模网络瘫痪。导致该区域内EC2实例失联、EBS存储卷无法访问。

2023年6月,US-EAST-1区域AWS Lambda和API Gateway的前端系统遇到问题,导致客户无法调用函数、更新或部署新应用。

加之此次故障,梳理近五年重大故障可以总结出几个关键规律。

一是核心区域的脆弱性,US-EAST-1区域几乎成为“故障高发地”。绝大部分重大故障都起源于US-EAST-1区域。这既是AWS部署最早、最大的区域,也是众多全球客户默认或首选部署的区域,其负载和复杂性最高,一旦发生故障,影响面最大。

二是“连锁效应”成为常态,单一服务的故障(如DynamoDB、Kinesis、ElastiCache)极易通过复杂的服务依赖链迅速放大,演变成波及数十项服务乃至整个区域的全面瘫痪。

三是故障根因多样化但聚焦,故障原因涵盖从物理网络设备、到DNS解析、再到API容量和软件bug等多个层面,但越来越多地指向内部核心管理系统或基础组件的失效,而非直接面向用户的终端服务。

AWS故障频发的背后,也暴露出全球云基础设施的深层矛盾。根据Synergy Research Group的数据,AWS是云基础设施技术领域的龙头企业,约占据三分之一的市场份额,领先于微软和谷歌。三者合计占比近70%,市场缺乏充分竞争使得基础架构升级动力不足。

更值得警惕的是“隐性成本削减”带来的风险。今年7月,AWS在云计算部门裁员数百人,上海AI研究院也宣布解散。对此,行业分析师曾指出,运维团队精简可能导致故障响应速度下降。

对于企业用户来说,此次AWS故障也再次证明,依赖单一云服务提供商的风险不可低估。行业中也早有“鸡蛋不要放在一个篮子里”的呼吁。面对不可避免的网络服务中断,企业应增强前瞻性,实施多区域部署、混合云策略并且建立实时故障转移机制。

究其根本,云服务是可靠的,但这种可靠性并非万无一失,而是需要企业与云服务商共同构建动态韧性,不是“永不断线”,而是能够平衡好“快速恢复”和“业务无损”。