近期,英伟达发布了其新一代 Rubin CPX,一款专为海量上下文处理的 GPU,能够使 AI 系统能够以突破性的速度和效率处理数百万个令牌的软件编码和生成视频。英伟达创始人兼首席执行官黄仁勋表示:“Vera Rubin平台将标志着AI计算领域的又一次飞跃——它不仅引入了下一代Rubin GPU,还推出了一种全新的处理器类别——CPX。正如RTX彻底改变了图形和物理AI一样,Rubin CPX是首款专为大规模上下文AI设计的CUDA GPU,它能够同时处理数百万个token的知识。” Rubin CPX 的核心创新是什么?为什么市场这么关注 Rubin CPX?对产业链有哪些利好?本文将进行详细地梳理。

Rubin CPX是什么

Rubin CPX介绍

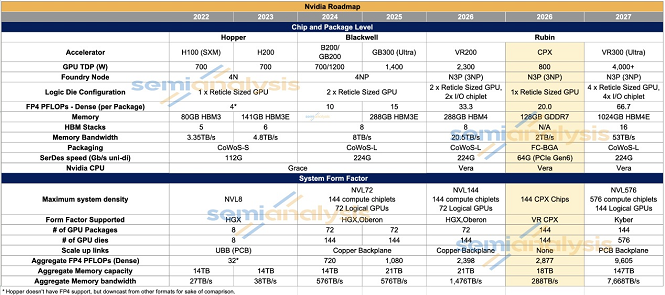

Rubin CPX 是英伟达于 2025 年 9 月 9 日推出的一款 GPU,全称为 Rubin 上下文处理单元(Rubin Context Processing Unit)。Rubin CPX 在英伟达AI版图中(见表1)属于Rubin代际,是专用的GPU,用于百万token长序列和视频的Prefill。能够显著降低智算集群的投资成本,进一步提升投资回报率,将于2026年底上市。

表1:英伟达AI芯片版图

Rubin CPX在计算与内存配置上体现了鲜明的专业化定位:它提供高达20 PFLOPS的FP4密集计算能力(稀疏计算下为30 PFLOPS),同时配备128GB的GDDR7内存,内存带宽为2 TB/s 。

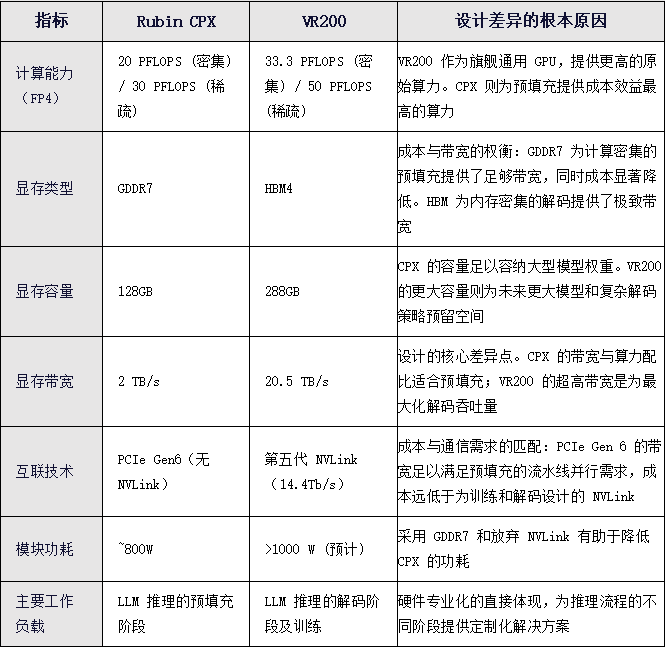

为了理解这一配置的精妙之处,必须将其与VR200 GPU进行对比(见表2)。VR200拥有33.3 PFLOPS的FP4密集计算能力和高达20.5 TB/s的内存带宽。通过计算“算力-带宽比”(FLOPS per unit of memory bandwidth),可以发现CPX的比值远高于VR200。这完美契合了推理Prefill预填充“计算密集型”工作负载的特性:需要强大的计算能力来处理并行任务,对内存带宽的要求相对宽松。

表2:英伟达Rubin CPX与VR200对比

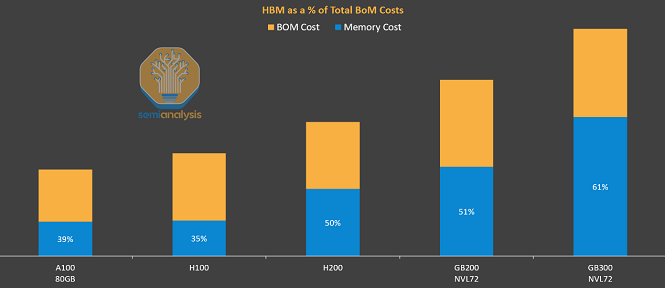

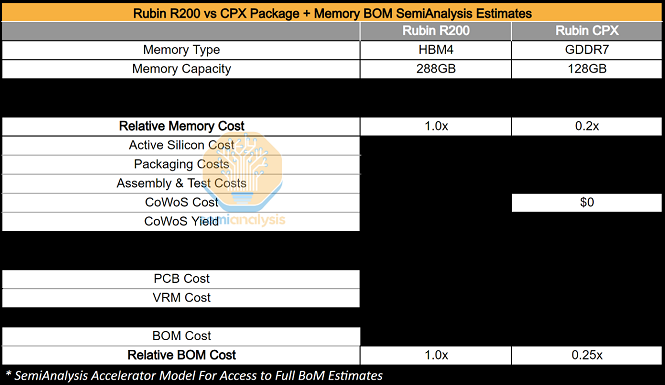

内存战略性选择GDDR7

内存一直是人工智能领域最重要的制约因素。为了将更大的模型加载到加速器中,需要更大的内存容量,而内存带宽则是推理和训练中令牌吞吐量的主要瓶颈。这就是为什么高带宽内存(HBM)的容量和每张GPU的带宽在过去几年迅速增长——从H100的80GB和3.4TB/s,到GB300的288GB和8.0TB/s,不到三年时间,内存容量增长了超过三倍,带宽也提升了约2.5倍。因此,从Hopper到Blackwell,HBM在加速器总成本(BOM)中的占比持续上升,如今HBM已成为GB300封装BOM中最大的单一组件(见表3)。

表3:HBM的成本占比

HBM对训练和推理都具有极高的价值,但当我们将推理过程分解为Prefill预填充和Decode解码两个步骤时,HBM仅在Decode解码步骤中具有高价值。在Prefill预填充阶段,由于计算密集型特性,KVCache的生成对带宽的需求相对较低,因为预填充本身具有并行性,因此在此阶段HBM的利用率较低。

GDDR7内存的应用是Rubin CPX经济模型的基石。与HBM相比,GDDR7每GB的成本降低了50%以上,使得CPX的内存成本相较于采用HBM的VR200降低了超过5倍 。这是一个颠覆性的成本削减。

这一决策的背后逻辑是,对于prefill预填充任务而言,2 TB/s的内存带宽已经“足够好”。通过大批量处理输入,可以有效地隐藏数据访问延迟,从而避免了对昂贵HBM的依赖。这一选择直接攻击了传统AI加速器中成本最高的组件之一,为实现极致的TCO优化铺平了道路。

放弃NVLink互联技术

Rubin CPX在互连技术上的选择,进一步展示了其成本优化的设计哲学。

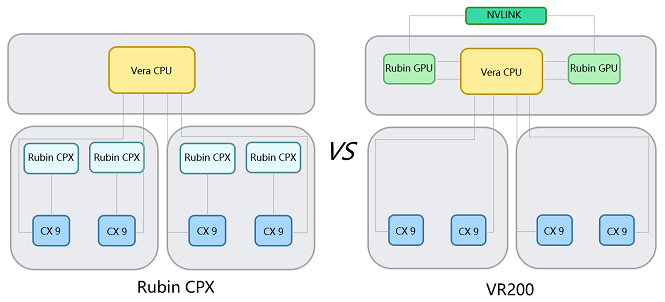

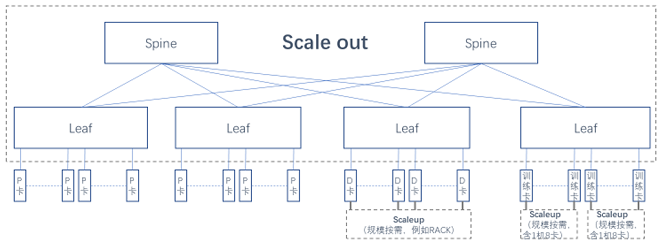

CPX放弃了昂贵且高功耗的NVLink互连技术,转而依赖PCIe Gen 6通过CX-9网卡通过scaleout网络与其他GPU进行通信(见图1)。NVLink是为训练和Decode解码阶段所需的高带宽、低延迟通信而设计的。然而,对于采用流水线并行(Pipeline Parallelism)的Prefill预填充任务,节点间的通信开销在总任务耗时中的占比较小。一个PCIe Gen 6 x16通道提供的约1 Tbit/s的单向带宽已足以满足需求,不会成为性能瓶颈。这一决策极大地削减了系统级别的成本和设计复杂性。

通过这一系列精准的“减法”,英伟达创造了一款完美适配其目标任务的加速器,所有非必需的昂贵特性都被无情地剔除。这不是简单的成本削减,而是为了实现经济霸权的精密工程。

图1 英伟达Rubin CPX与VR200拓扑结构

为什么引入Rubin CPX

将Rubin CPX的架构特性转化为商业语言,其核心价值在于性能的飞跃、成本的革命以及对市场动态的深远影响。英伟达短期目标是通过降低客户的TCO来赢得市场;长期目标则是重塑行业规则,占据行业主导权。

降低TCO,提升ROI,赢得市场

Rubin CPX的核心战略聚焦于“降低TCO(总体拥有成本)、提升ROI(投资回报率),进而抢占并扩容AI推理市场”。其关键在于“专业化分工”架构:将计算密集的Prefill预填充任务交由成本远低于VR200的CPX加速器处理(见表4),使得高价值、专为Decode解码优化的VR200得以解放,专注核心优势任务。这一设计大幅提升硬件系统资源的利用率,从架构层面实现成本与效率的平衡。

表4:Rubin R200与CPX成本对比

通过定性模型可直观其经济价值:假设推理任务中Prefill预填充与Decode解码各占50%耗时,传统架构下通用GPU需全程占用;而Rubin CPX架构中,低成本CPX独立完成Prefill预填充,VR200专注Decode解码,单位时间内VR200服务的解码请求量翻倍,ROI显著提升。尤其在长序列场景中,Prefill预填充耗时占比更高,成本节约效应更为突出,最终转化为“每推理token成本”的实质性下降。

当前高昂的推理成本是AI应用大规模部署的主要障碍。低成本Rubin CPX的出现,将激活因先前经济制约而无法实现的新应用,例如更强大的实时AI助手、全链路的企业级自动化流程、以及更具沉浸感的生成式AI内容创作工具。使用量的爆炸性增长将反过来创造对计算周期的海量、持续性需求。而英伟达凭借其高效且经济解决方案,在这个庞大的新兴市场上占据了最佳位置,获得了巨大份额,从存量博弈转向定义行业标准、塑造未来AI市场格局的核心赋能者。

重塑行业规则,掌握行业主导权

Rubin CPX 最致命的影响,是让竞争对手的现有技术路线图瞬间过时。AMD、谷歌、AWS、Meta 等企业需重新规划路线图,投入资源开发Prefill预填充专用芯片,这将大幅延缓其追赶英伟达的步伐。

以 AMD 为例,其待推出的 MI400 系列芯片原计划是对标R200,如今该策略已失效,其竞争对象不再是单一的R200 芯片,而是架构效率更高的 “R200 + CPX” 系统。AMD 陷入两难:要么推出系统 TCO 毫无竞争力的产品,要么推倒重来,耗时数年开发预填充/解码分离式方案,无论选哪条路,未来几年都可能将市场让给英伟达。

总而言之,Rubin CPX是一件“范式武器”。它通过改变游戏规则,将竞争从单一维度的芯片性能,提升到了多维度的系统效率和TCO。在这个新的战场上,只有英伟达提前数年布局,准备好了所有的棋子。

Rubin CPX的启示和未来方向

Rubin CPX是一场精心策划的“阳谋”

Rubin CPX不仅定义了当下,更揭示了AI硬件的未来演进方向。通过审视其设计哲学,我们可以推演英伟达及整个行业在未来的布局方向:极有可能出现面向解码的专用芯片组合,以专业化逻辑与海量内存子系统实现高性价比的解码加速。

如果说 CPX 是重计算、轻内存的芯片,那么其理想搭档将是一款反向设计的解码加速器:几乎全由海量 HBM 内存子系统构成,仅保留支撑自回归解码所需的关键计算逻辑。这种解耦设计把硬件资源的可组合性推向极致,使客户可以像搭建积木一样,根据具体工作负载的预填充/解码比例,精准、粒度地采购计算与内存资源,从而实现最终的总拥有成本(TCO)的极致优化。这也意味着 AI 基础设施将朝向完全可组合、软件定义硬件的方向稳步迈进。

英伟达通过将推理任务解耦为预填充和解码,并为前者打造专用、高性价比的CPX加速器,从根本上改变了AI推理的成本结构,为客户提供了无与伦比的TCO优势。更重要的是,这一战略举措迫使所有竞争对手重新审视其技术路线图,从而为英伟达赢得了宝贵的时间窗口,进一步巩固其市场领导地位。Rubin CPX不是一次简单的迭代,而是一场精心策划的“阳谋”,确保了英伟达在未来AI计算的浪潮中,继续稳坐浪潮之巅。

Scale out网络是AI 集群无可争议的通信底座

当前行业对超节点规模的追逐并非唯一答案。Rubin CPX 指出,在面向长序列的 Prefill 场景下,高性价比的解决方案才是核心竞争力,而非单纯追求硬件性能指标。未来英伟达的超节点将向如下两种形态发展:

1)VR NVL144 CPX单机架,每个计算托盘使用4个R200 GPU + 8个Rubin CPX GPU的配置。Rubin CPX GPU无NVLink连接,需要通过InfiniBand/以太网连接到集群,此方案的资源配置固定。

2)VR NVL144 + VR CPX双机架,即Rubin CPX GPU与R200 GPU分离部署,从而实现针对PD推理的专用硬件。Rubin CPX GPU无NVLink连接,需要通过InfiniBand/以太网连接到集群,此组合方案在资源配置上也更加灵活。

可以预见,未来的 AI 集群将呈现“不同类型芯片的混合组合 + Scale out 网络连接”(见图2)的形态,以便针对不同应用任务进行精准匹配并实现端到端的按需协同。故而笔者认为,AI 场景下的 Scale out网络不会被 Scale up 替代:前者是 AI 集群无可争议的通信底座,支撑不同类型加速卡的灵活协作与扩展,具备可预测的带宽与时延保障。后者仅适用于局部场景,为特定芯片(如 Decode解码或训练)提供按需小范围的高带宽互联。

图2:不同类型芯片的混合组合 + Scale out 网络连接

【参考文献】

1.《Another Giant Leap: The Rubin CPX Specialized Accelerator & Rack》from Semianalysis,链接:https://newsletter.semianalysis.com/p/another-giant-leap-the-rubin-cpx-specialized-accelerator-rack