通信世界网消息(CWW)近年来,随着数字经济的蓬勃发展,互联网、大数据、人工智能同各行各业深度融合,数据量和计算量呈指数级爆发,对于目前海量、分散的应用场景,数据的处理与分析需要强有力的算力提供支撑,加速了以“云、边、端”为主的算力资源的高效协同,同时服务形态也由最初的云服务向算力服务演进,促进算力技术发展走向多架构并存的道路。

异构算力广泛应用带来了软件、硬件、芯片层面新的技术问题,对算力资源的高效利用以及应用的快速发展提出了挑战,如何使用一套解决方案来屏蔽异构算力、异构代码和异构运行环境差异所引入的软硬件兼容问题,以便提高资源利用率、降低开发和维护成本,成为当前业界新的聚焦点。

在人工智能技术高速发展和广泛应用的背景下,电信运营商正在经历更深层次的变革。作为网络服务的提供商,运营商拥有场景应用、海量数据、计算资源等方面的独特优势,把人工智能技术引入到通信网络和相关业务等领域,能够加速网络智能化转型,提升服务质量,推动人工智能与实体经济深度融合。

算力服务原生概念

基于此背景,联通研究院未来网络研究部提出《中国联通算力服务原生白皮书》,并由中国联通研究院副院长唐雄燕在2023年云网智联大会主论坛上正式发布。白皮书所叙述算力服务原生技术的目标是:基于异构算力基础设施,面向应用、模型、代码在不同异构算力资源池间部署的使用场景,解决异构算力代码不通用、算力服务化成本高等问题,提高算力在各类场景下的应用效率。

算力服务原生是指屏蔽异构代码和异构运行环境间的差异,将一套应用代码封装为规范化的互联网服务,并可部署至任意位置和任意类型的算力上,供用户使用规范化互联网接口随时随地调用和消费。在此理念下,算力服务原生应实现大规模异构计算资源的统一输出,以普适性地满足不同量级或不同硬件架构下的算力需求。算力服务原生要统一算力输出的服务化标准,促进算力服务标准化,避免软件被固定形式的算力需求所捆绑,实现算力应用的标准化落地。

面向算力服务软件,算力服务原生将所有应用代码进行服务化封装,为用户提供统一规范化的服务访问接口和模式,使得所有应用代码(及其依附的算力设施)能够以服务的形式被用户所访问和使用,实现“代码即服务”“算力即服务”,简化普通用户使用、消费应用代码和算力设施的操作。

面向算力服务设施,算力服务原生屏蔽应用异构算力引入的复杂软硬件差异,实现“同一应用,同一套代码”。在无需改动的条件下,即可自动适配所有厂家的所有算力设备,应用在异构算力间无感知迁移,达到“一套代码,全网通用”的目的。

从应用对外提供服务所需的技术能力支撑维度,算力服务原生由软件到硬件、自上向下可分为5层,即应用层、服务层、算力抽象层、异构算力池化层以及设备层。算力服务原生技术集中在服务层、算力抽象层、异构算力池化层。

服务层维度的算力服务原生,旨在达到“代码即服务”“算力即服务”的目的,所谓“代码即服务”,是指开发者开发出一套应用代码之后,随即变成可部署至任意位置的规范化互联网服务,供用户使用规范化互联网接口随时随地调用和消费。由于服务化后的应用程序是依附在算力资源(设备)上运行并向外提供服务的,因此又达到了“算力即服务”的目的。

实现服务层维度的算力服务原生最基础和关键的技术是如何以简洁、规范、易用的方式将任意应用程序代码进行服务化封装,并为用户提供简洁、规范、易用的服务访问模式和工具。目前针对不同的编程语言基本有相应的Web服务化框架和工具,但是编程和使用模式都非常复杂,且互不兼容,即使一个简单应用的服务化封装,也需要专业开发人员才能实现,达不到服务原生的效果。

为了实现真正意义上的服务原生,即“代码即服务”,需要解决以下技术问题:面向异构编程语言的高并发、高性能微服务引擎,将任意编程语言开发的代码进行服务化封装;支持大规模高性能并发访问;支持多协议多数据格式传输适配;采用极简、规范化的接口代码开发模式;采用极简、规范化的接口访问模式;异构开发和运行环境适配;支持一键式自动化服务化封装。

中国联通研究院未来网络研究部成功研发了一套集AI模型自动化服务封装、发布、共享、部署和能力开放等功能于一体的开源AI服务原生平台和工具集软件——“CubeAI智立方”,其核心作用在于打通AI模型开发至实际生产应用之间的壁垒,加快AI创新和应用进程,实现“AI算力服务原生”和“模型即服务”,促进AI应用从设计、开发到部署、运营整个生命周期的自动化快速迭代和演进。

“CubeAI智立方”系统总体架构

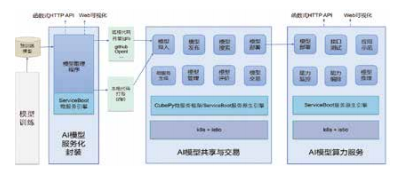

如图1所示,“CubeAI智立方”系统总体架构主要分为AI模型服务化封装、AI模型共享与交易、AI模型算力服务三大部分。

图1 “CubeAI智立方”系统总体架构

AI模型服务化

CubeAI平台的核心是AI模型服务化。通过使用自主研发的开源AI模型服务化引擎——ServiceBoot,AI模型开发者可以轻易将普通的AI模型推理程序封装成为可在互联网上运行的规范化Web服务(对外提供RESTful API或可视化图形界面等接口),并以容器化微服务的形式在CubeAI平台上进行共享、交易和部署。这就使得模型开发人员可专注于算法实现,而不必了解后续的封装、发布和部署细节;而模型用户也不必了解模型的算法实现和

部署流程,只需按照CubeAI自动生成的API接口进行调用即可。这样就在二者之间架设了一座互通的桥梁,使得各自能够专注于自己最擅长的领域,从而方便AI算法从设计、开发直到实际应用的整个过程。

AI模型共享与交易平台

经ServiceBoot服务化封装的AI模型,可一键发布至CubeAI模型共享平台。在模型发布过程中,CubeAI可自动将服务化的AI模型程序进行容器化封装,打包成容器化的Docker镜像,然后托管至模型共享平台,供用户浏览、检索、评论、交易和部署。容器化的AI模型经部署之后,将使用内嵌的ServiceBoot引擎对外提供Web服务(通过RESTful API接口或Web图形界面)。CubeAI同时还提供一种极简的自动化模型发布功能,支持以源代码方式一键自动发布至CubeAI平台进行共享和交易。

AI模型算力服务平台

理论上,用户可将CubeAI模型共享平台上发布的AI模型,部署至任意可运行Docker容器的环境来提供算力服务。为了方便使用,CubeAI专门开发了一个基于Kubernetes的AI模型算力服务平台,用于AI模型部署和运行。部署至CubeAI算力服务平台的模型以Docker容器方式运行于Kubernetes集群。使用能力网关对Kubernetes中运行的模型实例进行统一访问控制。针对部署于Kubernetes中的每一个模型实例,CubeAI提供了能力预览、能力监控、能力编排、生命周期管理、接口测试、可视化应用示范等操作界面,用户可通过API和Web可视化等交互方式进行在线模型推理。

“CubeAI智立方”开源理念

在“Cube A I智立方”立项研发之初,就将“开源开放”定位为一个基本的立足点和发展动力,在开源合作过程中,“CubeAI智立方”团队还积极参与AITISA联盟和启智社区组织的各类标准化工作和开源活动,例如启智开发者大会、启智校园行、全球智博会、CCF中国开源大会、极客有约人工智能开源录等,以展览、论坛和访谈节目等多种形式开展CubeAI相关的技术宣传和交流。鉴于在启智社区的积极表现和卓越贡献,“CubeAI智立方”在2021年和2022年的启智开发者大会上连续两年荣获“OpenI启智社区优秀项目奖”。当前“CubeAI智立方”已不再是一个单一的平台或组件,而是发展成为由一系列基础开发工具、应用服务平台和模型示范库等组成的系列开源软件,形成了“CubeAI智立方”开源生态体系。

中国联通研究院提出的算力服务原生理念,屏蔽异构代码和异构运行环境间的差异,将一套应用代码封装为规范化的互联网服务,并可部署至任意位置和任意类型的算力平台上,供用户使用规范化互联网接口随时随地调用和消费。在此理念下,算力服务原生实现大规模异构计算资源的统一输出,更加普适性地满足不同量级或不同硬件架构下的算力需求。算力服务原生要统一算力输出的服务化标准,促进算力服务标准化,避免软件被固定形式的算力需求所捆绑,实现算力应用的标准化落地。最终达到“一套代码,全网通用”的目标。